Mistral AI + GPT4All + Python API: LLM OpenSource Instalada localmente

Como baixar modelos da Start-up que levantou €385 Milhões na última semana

Este não é um post apenas para apresentar a concorrente da OpenAI e do ChatGPT.

Após o sucesso na rodada série A e levantar €385 Milhões de Euros, a companhia já é considerada a maior concorrente para 2024, então vamos para a prática e ver como obter os modelos.

Para isto, vamos usar o GPT4All, projeto que permite fazer download de modelos treinados de LLMs e usá-los offline, isto é, cuida de manter o deploy dos modelos e como bônus contém uma Interface Gráfica para interação no estilo ChatBot.

Além do modo gráfico, o GPT4All permite que usemos uma API comum para fazer chamadas dos modelos diretamente do Python.

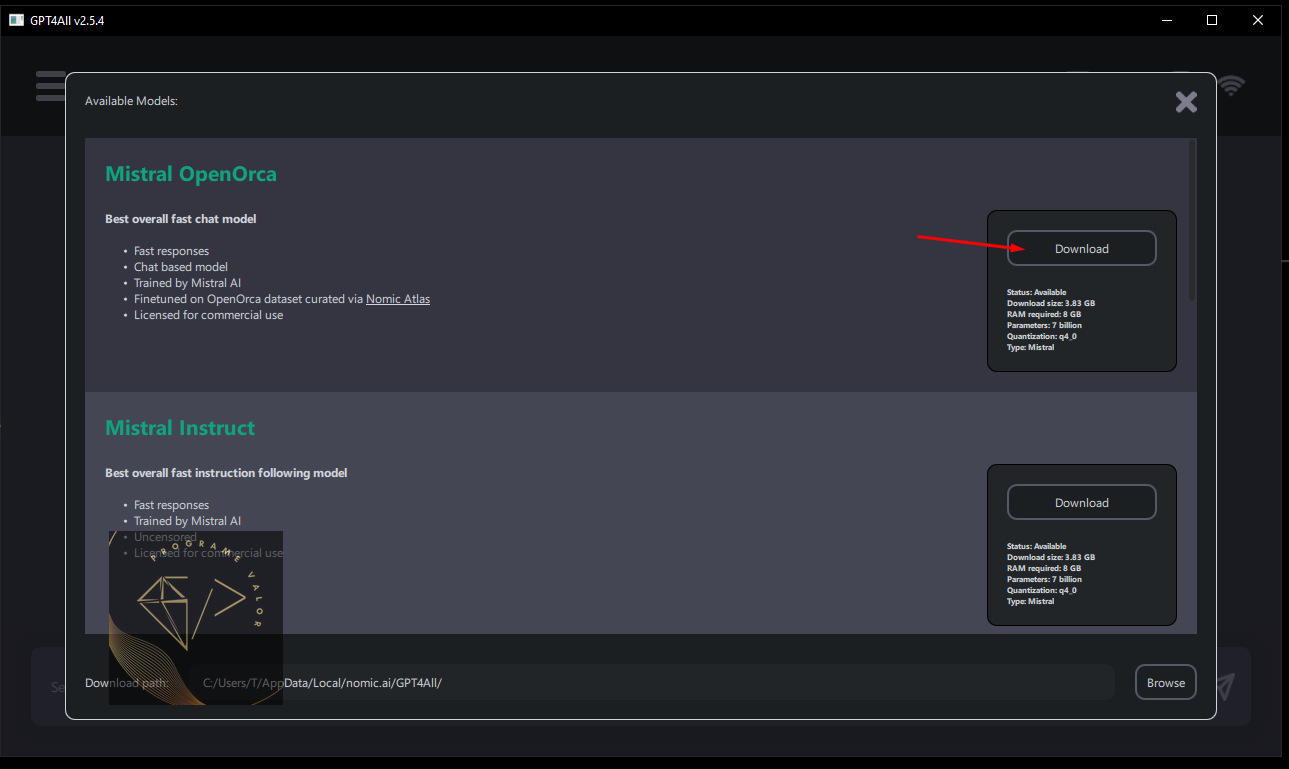

Dois destes modelos disponíveis, são o Mistral OpenOrca e Mistral Instruct. Ambos modelos de 7Bihões de parâmetros, com boa performance em operações gerais.

Rodando teste offline

Vamos começar pelo final e ver um pequeno exemplo do GPT4All rodando o modelo da Mistral AI localmente, sem conexão à internet e usando apenas a CPU.

Performance: ~6 tokens/segungo usando apenas uma CPU. O vídeo está com a velocidade da execução.

Instalação passo a passo

Vamos começar instalando o GPT4ALL, que irá gerenciar os modelos baixados e nos fornecer uma interface gráfica amigável para usar o modelo em formato de chat.

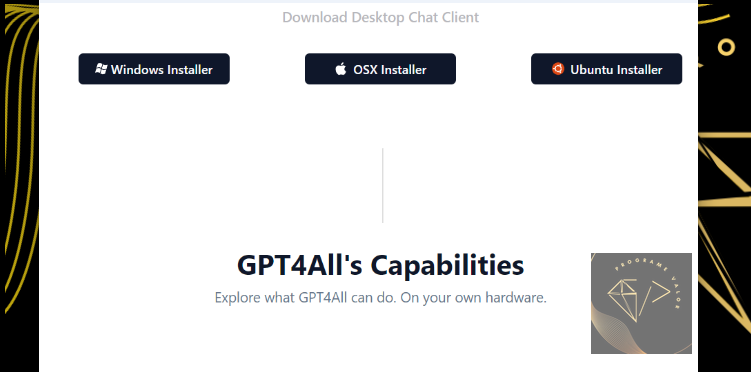

Baixar o instalador no site do GPT4ALL:

Site oficial do GPT4All: https://gpt4all.io/index.html

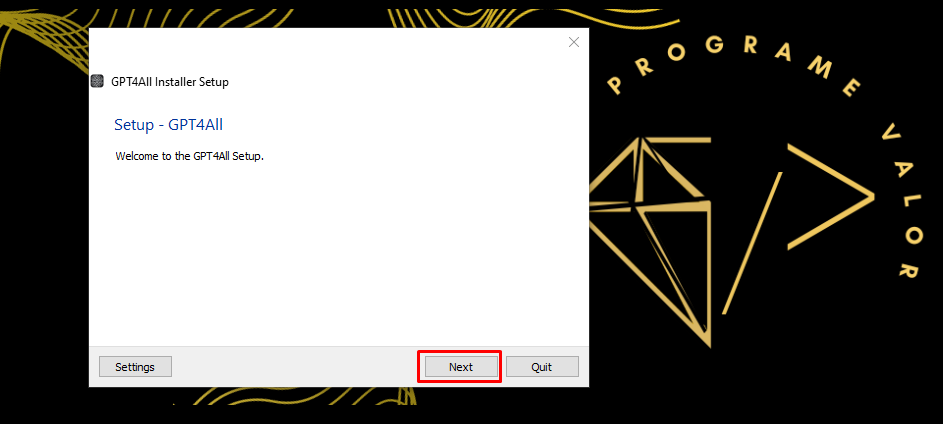

Abra o instalador e siga as opções padrão de instalação

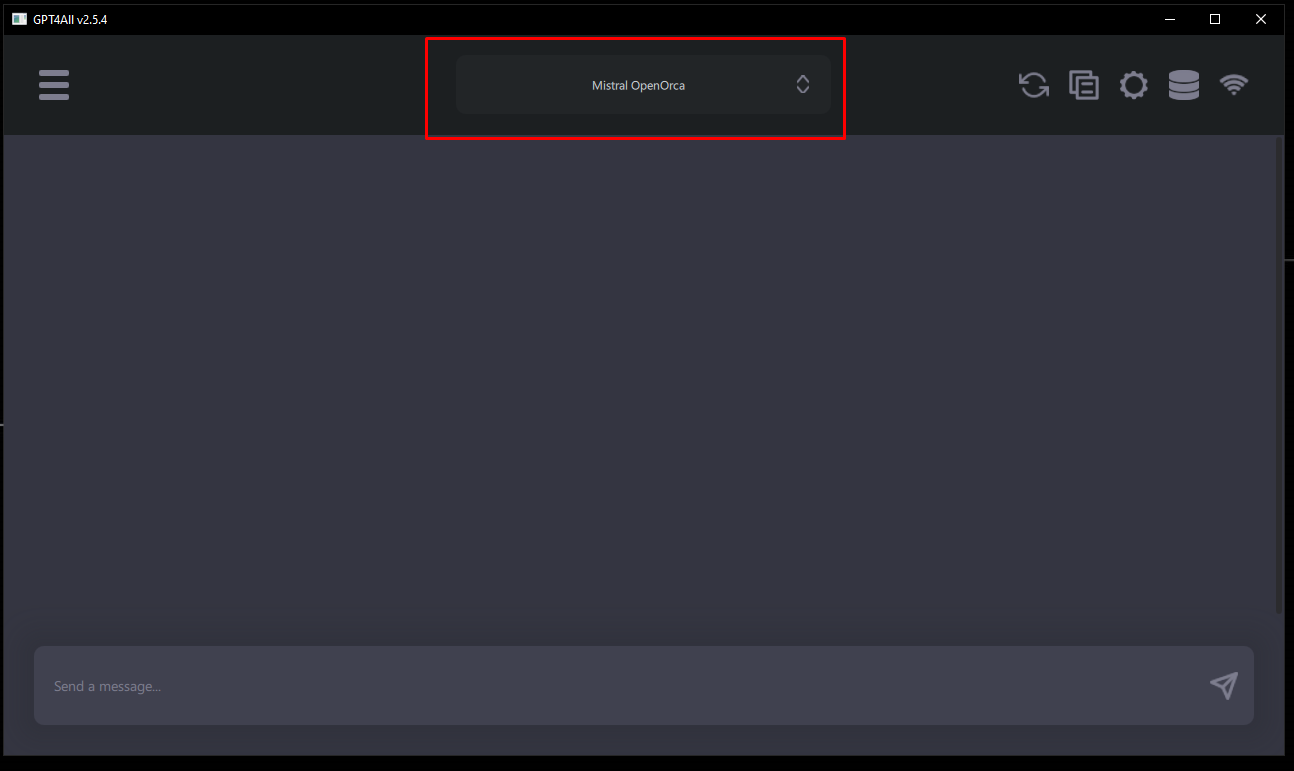

Abra o aplicativo GPT4All e Selecione o modelo para baixar

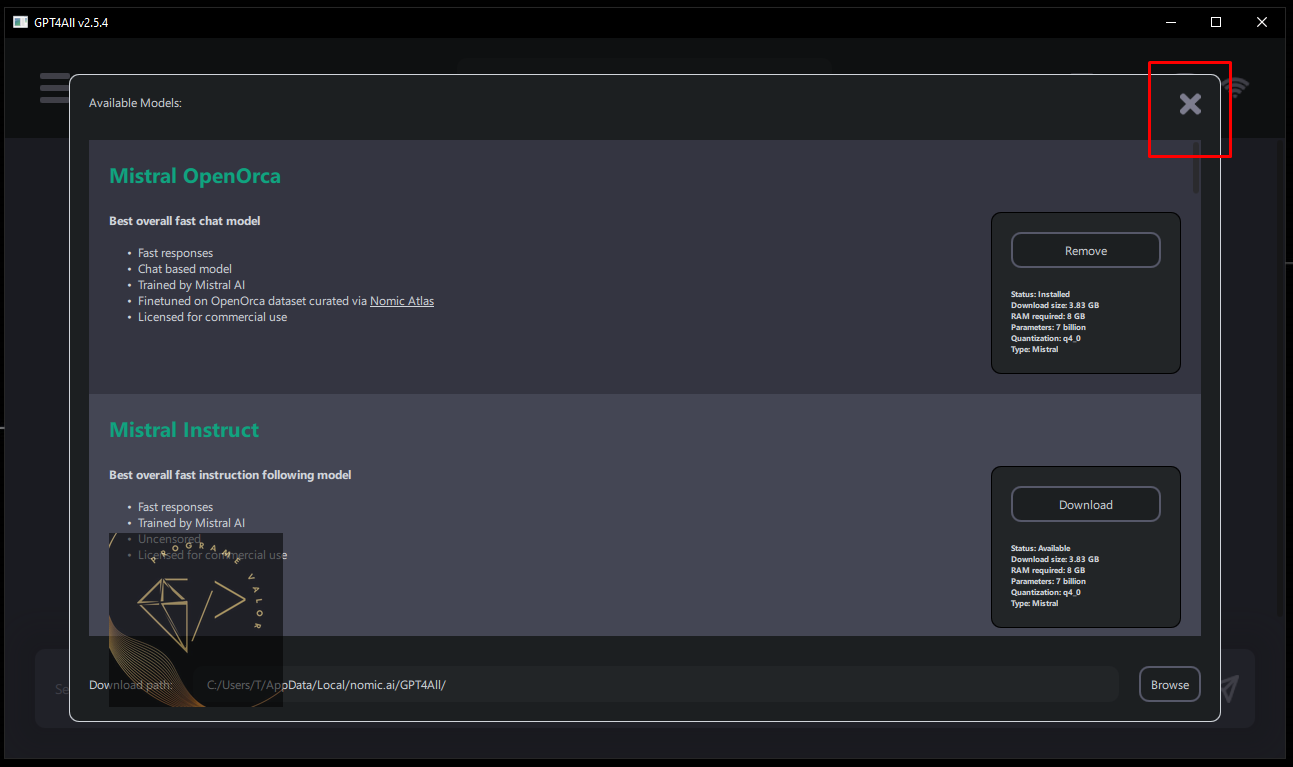

Após concluído, feche a janela de modelos

Parabéns! Agora já pode desfrutar do modelo totalmente offline.

Caso venha a instalar mais de um modelo, basta selecionar na janela de chat qual irá usar para a conversa.

Acesso via API em Python

Para usar a API, vamos instalar também o binding através do pip:

pip install gpt4allE em seguida já dentro do python definir qual modelo iremos usar:

from gpt4all import GPT4All

model_filename = "mistral-7b-openorca.Q4_0.gguf"

model = GPT4All(model_filename)

output = model.generate("The capital of France is ", max_tokens=3)

print(output)

# ParisPara os modelos da MistralAI, são estas 3 opções:

"mistral-7b-openorca.Q4_0.gguf"

"mistral-7b-instruct-v0.1.Q4_0.gguf"

"em_german_mistral_v01.Q4_0.gguf" (treinado para língua alemã)Para saber a lista completa de strings suportadas atualmente, consultei o json: https://raw.githubusercontent.com/nomic-ai/gpt4all/main/gpt4all-chat/metadata/models2.json

Para outras tarefas comuns com a API consulte a documentação: https://docs.gpt4all.io/gpt4all_python.html

Parabéns! Concluímos por aqui

Chegamos ao final e conseguimos:

2 tipos de instalação:

para interface gráfica e;

para Python API;

Conhecer o GPT4ALL

Usar os modelos da MistralAI

Este foi um post prático e espero trazer outro mais detalhado explorando alguns casos de uso no futuro. Então, se você gostou e quer fazer parte da comunidade já vai no compartilhar:

Pequena nota sobre a MistralAI

Fundada há apenas 7 meses e com a recente rodada de investimentos, a empresa já chega a 2bilhões de dólares de valuation.

A Mistral AI oferece modelos de código aberto facilitando a criação de produtos derivados, como chatbots e motores de busca.

A equipe da Mistral AI é composta por apenas 22 funcionários, incluindo cofundadores com experiência na Meta e no DeepMind, do Google.

Conta com um ex-secretário de Estado francês em seu conselho.

Onde mais encontrar a Mistral AI

Site da Startup: https://mistral.ai/

Modelos online no Hugging Face: https://huggingface.co/mistralai